近年来,在自然语言处理领域,基于预训练语言模型的方法已形成全新范式。本书内容分为基础知识、预训练语言模型,以及实践与应用3个部分,共9章。第一部分全面、系统地介绍自然语言处理、神经网络和预训练语言模型的相关知识。第二部分介绍几种具有代表性的预训练语言模型的原理和机制(涉及注意力机制和Transformer模型),包括BERT及其变种,以及近年来发展迅猛的GPT和提示工程。第三部分介绍了基于LangChain和ChatGLM-6B的知识库问答系统、基于大型语言模型的自然语言处理任务应用研究和大模型训练实战等具体应用,旨在从应用的角度加深读者对预训练语言模型理论的理解,便于读者在实践中提高技能,达到理论和实践的统一。

本书适合计算机相关专业的学生,以及其他对预训练语言模型感兴趣的读者阅读。

作者简介:

徐双双,自然语言处理工程师,在机器学习、深度学习和自然语言处理领域有十余年的算法研发经验,曾在一线大厂阿里巴巴、京东等担任过资深算法工程师和算法经理等职,现在在世界500强公司担任自然语言处理团队负责人,负责过金融和医疗领域的知识图谱、智能问答系统、文本生成系统等企业级核心项目。

目录:

第1章 自然语言处理介绍 2

第2章 神经网络预备知识 18

第3章 预训练语言模型基础知识 44

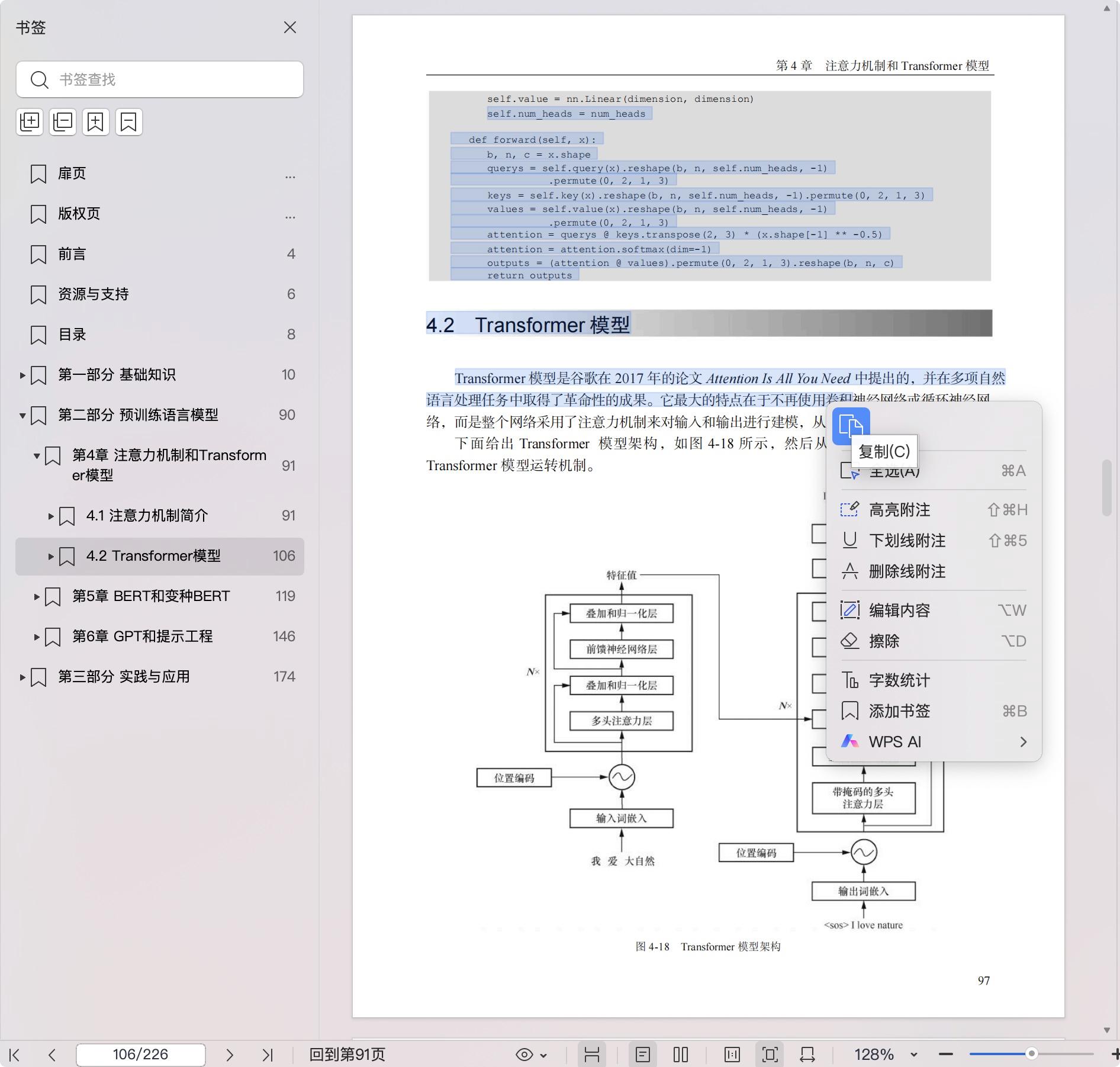

第4章 注意力机制和Transformer模型 82

第5章 BERT和变种BERT 110

第6章 GPT和提示工程 137

第7章 基于LangChain和ChatGLM-6B的知识库问答系统 166

第8章 基于大型语言模型的自然语言处理任务应用研究 178

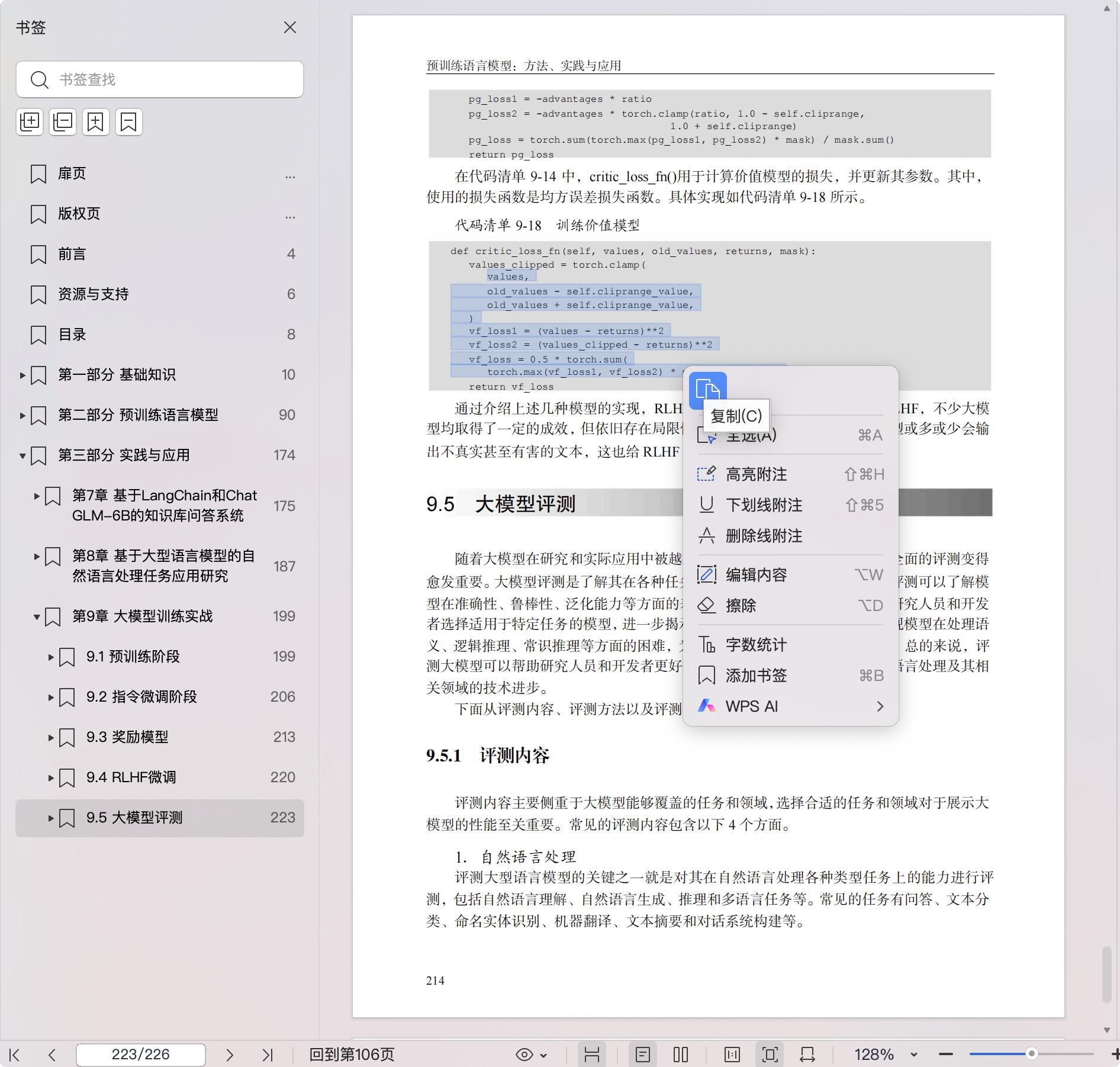

第9章 大模型训练实战 190

点击下载